Why?

- 延伸之前推論出的VC Dimension,嘗試把適用範圍拓展到不同的問題上。

雜訊問題:可能答案標錯,可能資料本身有錯,都是雜訊

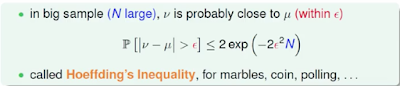

機器學習就像從瓶子裡面拿彈珠,以前彈珠好壞比例固定(deterministic),雜訊存在時彈珠好壞則是隨機的(stochastic)有可能同一個判斷(hypothesis)有時好有時壞,但是依然可以推論VC Dimension是通用的,有雜訊時也是可以學習的。

- 換一種角度,直覺的思考:

如果今天好的資料機率0.7,壞的資料0.3(stochastic),那我們可以找出一個mini-target,根據大部分資料的特性來當作學習目標,此時壞的資料就當作雜訊。

Error Measure:

很多時候error會根據不同目標而不同,在選擇學習演算法時,通常我們會選擇一個可行的或者友善的來學習。可行的是指我們對那個data domain的知識人為判斷,友善的是指針對資料特性找出能快速降低錯誤的方法。(err-head: 是我們設計的error measures)

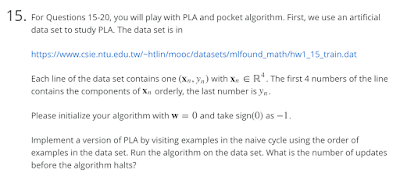

上圖在討論一個直覺的想法,先前以證明過PLA是可以學習的,但現在學習演算法改變,出現了權重來影響學習,此時可以透過virtual copy來達到reduction效果(把一個問題推論另外一個問題,此時就可以證明在條件下可通用,這是很常看到的方法)- 另外值得一提的是,weighted classification也可以用來解決data unbalance的問題(譬如說罹患癌症的比例在資料中非常少)